桜はカンザンという種類だった。また駅前に行ったついでに木の植えられたところに行った。近くに寄ってよく見た。木の幹を支える、鳥居に組まれた柱に小さな銘板が付いていた。植えられた日付とともに「カンザン」と書かれていた。

Wikipediaによると、「桜漬けはカンザンが原料として多く用いられる」とあった。どうりで、花を間近で見たときに桜湯を思い起こしたわけだ。

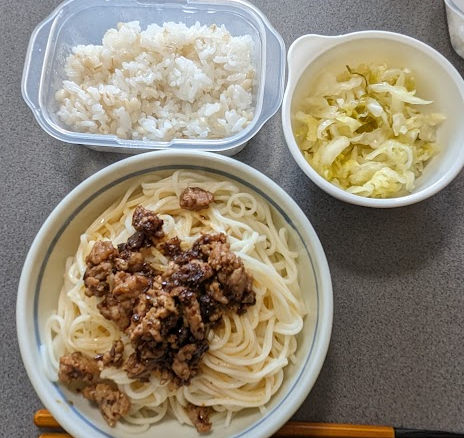

昼は担々麺。久しぶりで麺の量がわからなくなった。適当に掴んで鍋に投入した。茹であがりは欲しかった量よりちょっと多かった。たっぷり食べられて結果的に成功だった。

人が多くなる前にと、16時ごろドラッグストアに買い出しに行った。帰りにサイゼリヤで食事。私はペペロンチーノとチーズのドリア、それと青豆温サラダ。家族はスパゲッティを2つ。各々がメインの皿を2つずつ食べた。食べ盛りの若者みたいな食事をした。大変満足した。満腹になった。

家に帰り、夜を待った。部屋の中、各自の定位置でそれぞれ自分のタブレットの画面を見て過ごした。気がつくと眠ってしまっていた、家族も眠っていた。いつもなら晩御飯を食べ終わったぐらいの時間だった。順番に風呂に入って、また漫然と画面を見ながら就寝時間を待った。

たんぽぽの花、あった。すぱっと切られた茎と並んで、花が生き残ってた。半分ぐらい花びらを失っている。身を切られながらも薙ぎ払う刃に抗わず、茎を倒して地面に屈むことで刃の下をくぐることができたのだろう。

ゆで卵の作り方を見直した。決まった鍋、冷蔵庫の冷えた卵。少ない水を沸騰させ約5分加熱、火を止めて約5分置く。黄身の茹で加減は待つ時間で調節する。とろとろの黄身にしようとすると白身までとろとろで殻を剥くときに崩れて扱いづらかった。いままでは沸騰してからは火を弱めていた、それがうまくいかない理由だったかも。やり方を変えてみた。沸騰しても火を弱めずに約5分間ガンガン加熱して、火を止めて3分。成功した。白身は固くて殻も剥きやすいけど黄身はとろとろにできた。やったね✌

黄砂の影響か、点鼻薬を一回プシュっとしただけでは鼻水が止まらなかった。もう一度プシュっとしてなんとかおさまった。薬を吹き付けると直後のほんの短い時間だけ、頭がふわーっとしてぐるぐるまわる。副作用的なものか、薬が鼻によく浸みるように静かに長く息を吸うせいなのかは分からない。サウナの後の水風呂にも似たような低いレベルでの意識の強制的な揺さぶりがたのしい。

きのこのみそ汁に高野豆腐、チーズをのっけた。小松菜おひたしの汁が多く残ってもったいなかったからみそ汁に入れてみた。みりんとしょうゆでみそ汁の味が締まるかと期待したのだけれど、えぐ味だけが強調された。まずいみそ汁になってしまった。すりごまを入れたらえぐ味がごまかせた。